超节点选型:跳出性能迷局,聚焦稳定与落地价值

2025.12.03 17:29浏览量:91简介:唯有让超节点的部署和运行体验达到「和单机 8 卡机一样」高效、顺畅与稳定,才能尽早且持久兑现性能红利

1. 模型持续演进,AI Infra 需要更大的 Scale-up 网络域

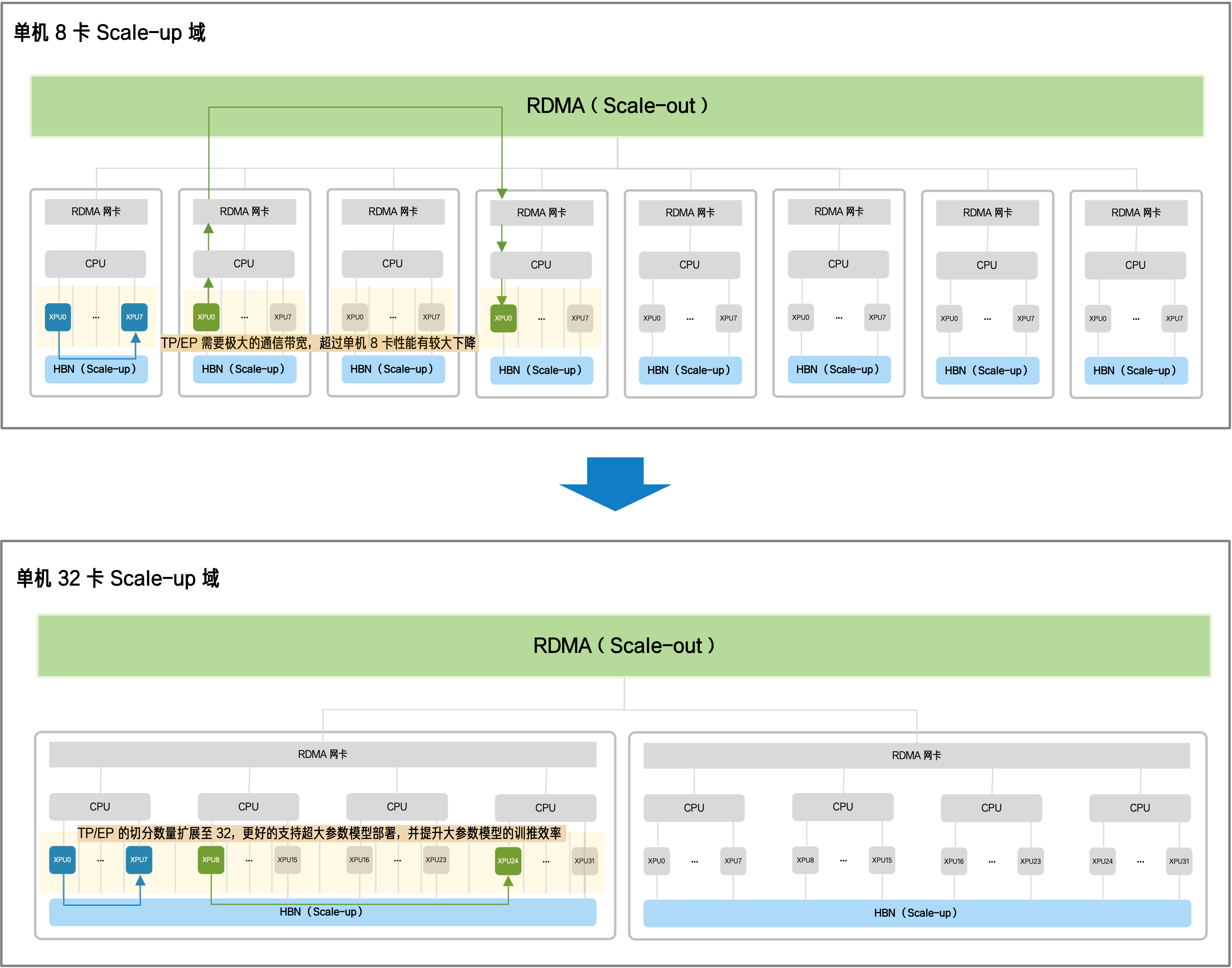

当前主流的 AI 算力架构,是以单机 8 卡为基础计算单元,通过 Scale-out 网络连接多个单元,组成千卡、万卡集群,采用并行策略实现大规模并行计算。但随着模型规模的持续扩张与模型结构的演进变化,Scale-out 网络的通信效率开始成为制约系统性能的瓶颈。

比如,随着 PD 分离部署、MoE 模型架构等方案的广泛采用,算力规模更大、专家协作更多,卡间通信急剧增加,且对带宽和延迟的要求更高。而 Scale-out 网络普遍采用的 RDMA 技术带宽有限、且数据传输需经「多跳搬运」耗时过长,极大掣肘了 AI 业务的吞吐性能与响应速度。

为破解这一困境,行业的共识是:扩大 scale-up 域,把更多 AI 芯片聚合成「一颗超级芯片」,此时,机间通讯变为机内卡间通讯,通过全互联架构实现极致性能突破。其价值体现在三方面:

提升通信效率:更大的 Scale-up 域将全互联架构拓展至几十至数百张 XPU 卡规模,将每一颗 XPU 的双向带宽提升 TB/s 级别,通信时延极限压缩至 1~2 微秒内,显著缩短推理响应时间和训练周期;

适配更大模型参数,实现高效切分:更大的 Scale-up 域不仅支持超大参数模型部署,更能为上层框架提供精细化、高效化的模型切分方案,进而优化显存分配,在更大参数规模时依然保持极高的训推效率;

匹配未来模型发展方向:高稀疏度的 MoE 模型依赖更大规模的通信域来释放潜力,更大的 Scale-up 域,可以设计、训练「稀疏度更高的 MoE 模型」,进一步提升模型效果,推动下一代 MoE 模型发展。

2. 超节点:超越性能,聚焦落地价值

在这种对更大算力域的迫切需求下,超节点应运而生 —— 它通过将计算、通信、供电、冷却等多个组件进行更高密度的一体化整合,使几十张乃至数百张 XPU 芯片在高带宽、低延迟的环境下互联与协同,从而实现算力资源的调度与利用效率的双重提升。并因此成为支撑大模型规模化落地的最佳架构选择。

然而,作为集高密度芯片、内存、网络、电源、制冷于一体的系统级产品,超节点数十 U 的整机柜形态、海量组件的复杂性与高昂的初期投入,要求企业在选型时,必须将评估重点从理论性能转移至实际部署的效率与可靠性。

这一战略聚焦在当前显得尤为关键,因为在超节点的早期市场阶段,技术路线多元、行业规范尚未统一,从传统服务器到「整机柜」形态的转变,使得企业现有的软硬件配套设施——无论是机房环境的承载极限,还是运维团队对高密系统的管理经验——都面临着严峻的落地适配挑战。

因此,超节点产品设计要立足于客户的实际部署需求和使用习惯,通过高度通用化、标准化的产品形态,超节点能够主动填补企业现有基础设施与前沿算力技术之间的鸿沟,从而最大程度降低企业的试错成本与技术风险。

为此,在超节点的早期市场阶段,对那些计划将其部署于自有 IDC 机房的企业而言,选型评估不能仅停留在性能参数的比拼,更要聚焦于可落地性。

唯有让超节点的部署和运行体验达到「和单机 8 卡机一样」高效、顺畅与稳定,才能将超节点的性能红利尽早且持久地转化为企业实际的业务效益。

此时,企业需围绕以下三大核心维度展开全面评估:

性能收益的转化:如何将超节点的性能优势有效转化为业务效益的提升?在不同的场景需求下,采用何种规模的方案,才能实现性能与成本的最优平衡,最大化投资回报率(ROI)?

运行的稳定性:超节点内组件高密聚集,带来散热、信号干扰等工程挑战。如何通过热管理和链路简洁性设计有效规避潜在风险,保障算力在长期高负载下的持续、可靠输出?

部署与运维的效率:超节点作为机柜级产品,是否会带来更为复杂的连线与配置操作,从而影响业务上线效率?缺乏相关经验的企业运维团队,又该如何借助产品设计实现快速上手与便捷管理?

2.1. 性能收益:如何将硬件潜力最大化兑现为业务效益?

超节点的性能参数最终要兑现为业务效益,其关键在于 —— 通过软件栈优化让硬件潜力在实际任务中得到最大发挥,并通过合理化规模设计让算力投入匹配业务需求,提升企业投资回报率。

软件栈优化:释放硬件潜能,降低 TCO(总体拥有成本)

超节点通过扩大高带宽、低延迟的 Scale-up 域,从硬件层面显著压缩了通信开销,为上层软件栈的深度优化创造了空间。这直接提升了 AI 芯片的实际利用率(MFU)和性能兑现率。

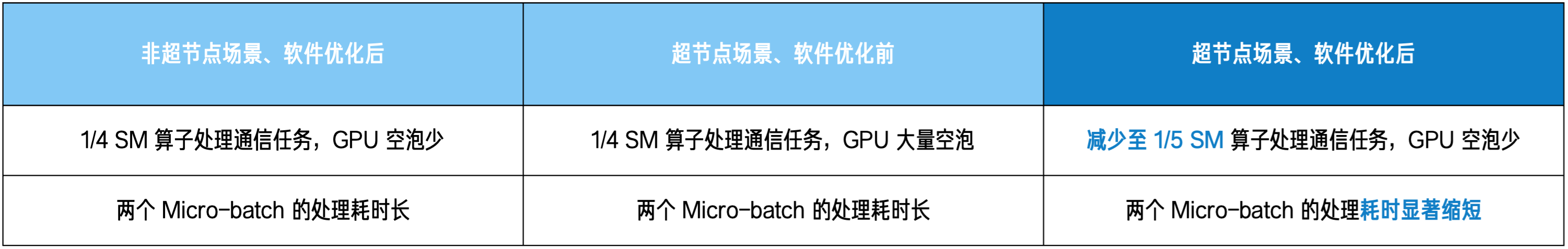

以 MoE 模型的 Prefill 阶段为例:AI 芯片间需要进行高频次的 AlltoAll 通信(如 Dispatch 和 Combine )。在非超节点场景中,受限于网络带宽和延迟,通信占用了较多的 SM(Streaming Multiprocessor)算子资源;而超节点凭借极致互联,大幅缩短通信时长。调度层面因此能将更多的 SM 算子资源释放给计算任务,实现计算与通信的高效重叠(Overlap),显著提升整体效率。

配合 IO、数据加载及通信库的进一步优化,这种「硬件先行,软件跟进」的策略能持续释放硬件潜能,显著提高 MFU,并最终实现每 Token 成本的大幅降低。

例如,以 NVL72 超节点为代表的方案,通过持续的软件栈优化,GB200 模型的训练成本在仅仅两个月内实现了超过 50% 的降幅,单 Token 成本从 0.468 美元降至 0.307 美元,带来了 1.5 倍的 TCO 优势。

合理化规模:平衡性能与成本,提升 ROI

超节点的规模建设关乎长期 ROI,企业需在「性能需求」与「成本投入」间,找到动态平衡点。

当前市场阶段,主流模型集中在千亿参数级及以下,32 / 64 卡规模的超节点已经能够很好的承载推理及训练对算力的需求 —— 它既能通过扩大 Scale-up 域显著提升推理性能和训练效率,又能有效避免因过度超前投资而导致的资源闲置,实现更优的成本控制。

面向未来,随着模型参数进一步发展,MoE 架构的专家数量增长,更大规模的超节点将成为刚需。对此,领先厂商已经开始前瞻性布局,积极投入研发和设计更大 Scale-up 域的超节点,以应对未来的算力挑战。企业需结合当下业务与未来发展,找到性能与成本的动态平衡点。

2.2. 稳定性:如何确保超高性能的持续、可靠输出?

超节点以高密度架构追求性能峰值的同时,也放大了系统工程的复杂性:组件数量的爆发式增长(如 NVL 72 超节点铜缆线多达 5184 根、CloudMatrix 384 超节点光模块数量多达 6912 个),使得系统故障风险指数级增加;其高密度集中部署更使热流管理、信号完整性等问题被急剧放大,成为影响系统长期运行的关键变量。

超节点的稳定性设计主要围绕「核心组件的物理稳定」和「组件间的互联稳定」两个方向展开。

核心组件的稳定性:热管理与精细布局

高密度集成的超节点在长期运行过程中,面临的首要挑战便是散热问题。尤其针对 XPU、网卡等对温度敏感、故障率较高的关键组件,超节点设计必须在制冷方式和热流路径上进行精细的调试。

- XPU 芯片的稳定性保障:液冷是核心

在智算场景中,XPU 芯片因持续高温运行是故障率最高的组件,超节点的高密度部署进一步加剧了高热的聚集,系统稳定性受到挑战。而传统风冷不仅散热效率较差,更无法显著降低 XPU 的工作温度,因此超节点必须采用液冷方案。液冷方案高效的散热能力可以将 XPU 工作温度降低 20% 左右,显著提升超节点的长期运行稳定性。

而考虑到全液冷方案对机房管路(上、下进水)要求较高,对老旧机房不友好。因此,风液混合冷却方案成为兼顾效率与兼容性的选择 —— 它通过独立的液冷循环装置(如 CDU),快速带走 XPU 局部热量,再利用机房原有风冷系统完成整体散热,保障系统稳定性的同时,显著降低了对基础设施的改造要求。

- IO 模块的精细布局与冷却考量

高性能网卡等 IO 模块对工作温度高度敏感,温度上升容易引起网络抖动,影响性能。对此,一些超节点产品会充分考虑机柜内部的热场分布,采用远离主要热源的布局方式,确保网卡等关键通信模块工作在更稳定、更低温的环境中,从而减少因过热导致的通信错误或故障风险。

组件互联的稳定性:链路简洁性设计

在超节点内部,通信链路的任何波动都可能导致集群计算中断或性能骤降。因此,组件间互联的简洁性设计至关重要。简洁设计意味着更少、更短的连线布局和更少的接触点,能显著提升整个系统组件协同的稳定性。

XPU - XPU 互联的最短路径与一跳交换:为保障效率和稳定性,XPU 卡间互联应最大限度地减少通信距离,并避免跨越多层 Switch 转换,尽可能实现一跳交换的简洁路径,有效降低信号衰减和调度延迟带来的不确定性。

XPU - CPU 互联要减少断点,采用直连:XPU - CPU 互联是指令和数据传递的枢纽,一旦出现问题,会导致 GPU「无数据可算」或「指令混乱」,严重影响系统稳定。因此,其互联也应最大限度减少通信距离,降低接触点数量。所以,XPU 与 CPU 之间的互联设计,应尽可能规避解耦设计,避免高速信号流经如「PCB 板、高密连接器、长 Cable、高密连接器、转接芯片、高速 PCB 板」这类的长距传输。

线缆的简洁部署:大量复杂的线缆布局会使组件受到外界干扰,并增加人为出错风险。因此,集成化、模块化的简洁线缆设计是保障系统稳定性的重要一环。

对企业而言,超节点的稳定性是保障高性能「长跑」的生命线。只有当超节点产品具备更低的组件故障率和更完整的信号传输方案时,才能确保算力投资持续、稳定地转化为业务产出。

2.3. 可落地性:加速部署、简化运维,实现快速价值转化

超节点作为一种全新的机柜级产品形态,其落地效率直接影响算力投资的回报周期。对于企业客户而言,一套具备高度通用性、标准化的部署方案至关重要。它能最大程度减少企业对机房的改造投入,缩短落地周期。

强兼容的产品设计与标准化落地:适应各种 IDC 场景

超节点的高密度特性对机房的供电与冷却系统提出了更高要求,其与现有环境的兼容性直接影响部署效率与建设成本。

物理架构与供电的适配:采用标准尺寸设计的超节点机柜,能保持与现有 IDC 通道、机位的一致性,大幅缩减运输与进场的准备周期。在供电方面,为避免大规模供电系统重构的风险,超节点产品应具备广泛的电力兼容性(如支持 AC/AC、高压直流、单相供电、三相供电等),并通过极致的能效控制降低单柜能耗,使机房人员无需进行复杂的并柜操作即可满足电力需求。

灵活多样的冷却策略:制冷是超节点落地的最大瓶颈。针对已具备液冷条件的新建机房,企业需要产品能灵活兼容上、下进水等不同管路设计;而针对大量尚未进行液冷改造的老旧机房,企业则需高效的风液混合冷却方案,在不进行「伤筋动骨」的基础设施改造前提下,解决高密度机柜散热难题,确保业务快速上线。

「上电即用」的快速部署与「易上手」的便捷运维:降低应用上线门槛

硬件兼容只是第一步,面对内部高度集成的复杂系统,如何降低部署门槛与运维难度,是决定业务上线效率的关键。

网络部署,「0 连线 0 配置」的极速体验。面对动辄数百张芯片的集群,企业最担心的就是陷入漫长的现场连线与网络调试。因此,具备「0 连线、0 配置」能力的超节点产品可以很好的解决客户的顾虑,客户在现场仅需完成物理供电,即可直接部署模型进行推理和训练,将原本数周的部署周期压缩至数小时,实现真正的「上电即用」。

节点运维,「模块化减负」消除维护焦虑。超节点的体积与重量巨大,内部线缆复杂,给运维人员带来了巨大的操作难度。对此,一些超节点产品采用了 「1U 一节点」设计,在进行故障排查或硬件更换时,运维人员无需搬动沉重的机架或处理复杂的线缆连接,只需轻松抽拉处理单个节点,并通过超节点所支持的水、电、网「盲插」能力,极大降低了物理操作门槛,实现一线 1 人运维,也能安全、高效地完成维护工作,有效规避了 10U 系统故障时动辄 2~4 人的运维需求,更加人性化和简单化。

3. 结语

在超节点这一创新算力形态的早期发展阶段,企业部署超节点时,不能唯性能论,否则极易陷入「高性能却难落地」的困境。唯有跳出性能迷局,聚焦超节点与业务场景的贴合度、与现有基础设施的兼容性,从性能转化、稳定性、可落地性多维度综合考量,才能让超节点真正落地,让高性能算力平稳转化为可持续的业务价值。

发表评论

登录后可评论,请前往 登录 或 注册